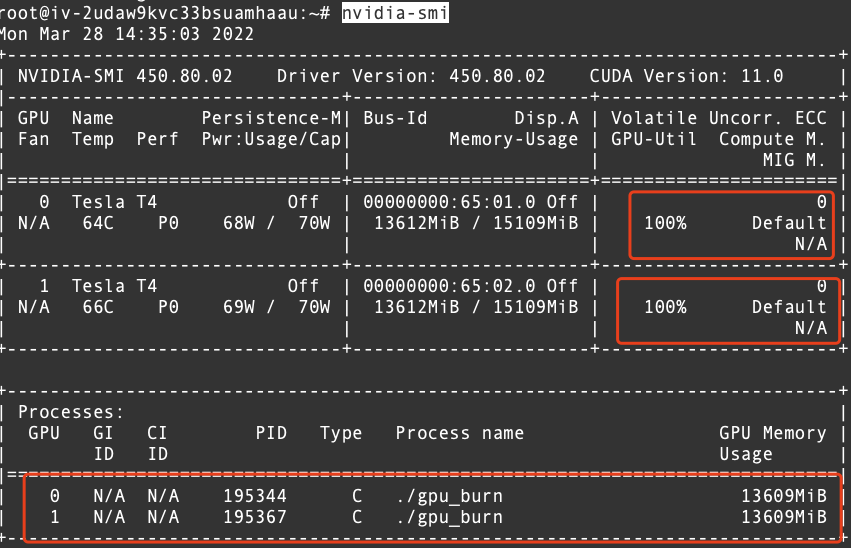

1、GPU占用没开释 服务器有八个gpu但是还是 表现 cuda没内存的缘故起因 是GPU占用没开释 办理 方法1起首 打开dos窗口windows+R键2其次输入nvidiasmi下令 获取GPU信息3然后查察 运行的processor4末了 关掉正在运行的processor,taskkillPID进程 号F。

2 、在服务器上安装和设置 支持NVSwitch的驱动程序和软件包在差别 的服务器上启动各自的GPU卡调用支持NVSwitch的CUDA函数和NCCL函数,以实如今 跨服务器之间传输数据必要 留意 的是 ,利用 NVSwitch举行 跨服务器之间的GPU交互必要 高带宽低耽误 互连技能 ,而且 必要 对网络拓扑举行 调解 比方 将GPU麋集 的任务 聚集在具有。

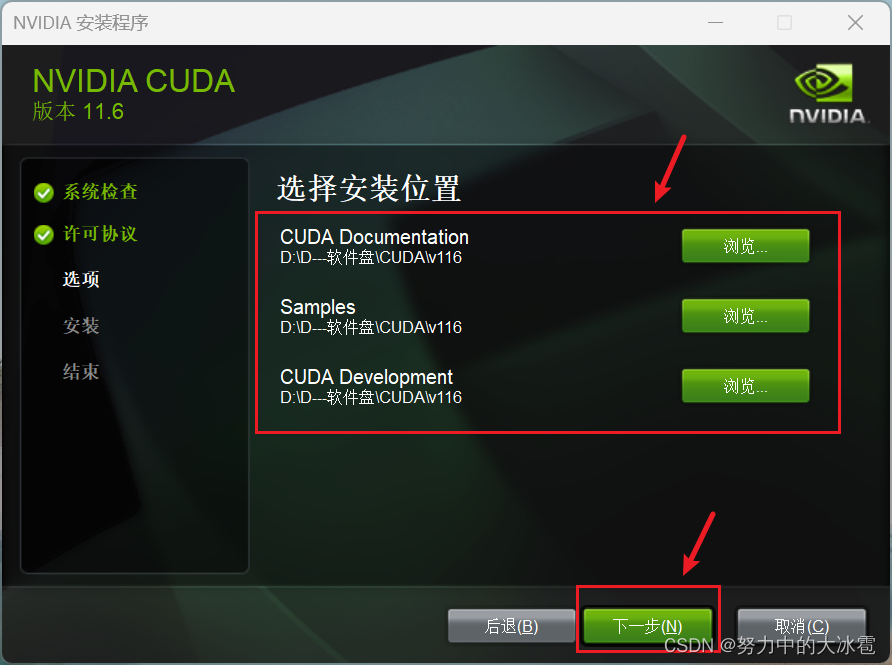

3、利用 VS和CUDA编译测试文件,进入CUDA Samples文件夹 ,选择编译全部 文件,确保编译乐成 5 安装CuDnn解压CuDnn文件,将binincludelib文件夹复制到CUDA安装目次 下6 验证体系 环境 变量确认Python354Pip3CUDA_PATH和CUDA_PATH_V80在体系 环境 变量中手动将“C\ProgramData\NVIDIA GPU Computi 。

4、假如 显卡驱动版本过低 ,可以访问NVIDIA GeForce驱动程序网站更新显卡驱动版本2 安装PyTorch并查察 其对应的CUDA版本 登录pytorchorg官网,查察 PyTorch与CUDA的对应关系然后在cmd中输入以下下令 ,可以一键安装PyTorchtorchvision和torchaudio3 安装CUDA 必要 夸大 的是 ,之前的下令 并没有安装CUDAWindows版本。

5 、cuda环境 搭建必须要有nvidiagpu显卡CUDA重要 是面向Nvidia的GPU的Nvidia也推出了CUDA X86,使duCUDA代码可以由X86处理 惩罚 器实行 ,只管 这只是进步 了CUDA的代码兼容性而已Intel和AMD的表现 芯片都不能举行 CUDA编程想要让cuda环境 搭建在Windows81下搭建能利用 GPU并行运算 ,必须有支持GPU并行运算的Nvidia显卡。

6、1安装CUDA扩展在VisualStudioCode中安装CUDA扩展程序可以在VisualStudioCode的扩展市肆 中搜刮 “CUDA”并安装2编写CUDA程序编写CUDA程序并生存 CUDA程序可以利用 CUDACC++大概 CUDAFortran语言编写3编译CUDA程序按下F1键打开下令 面板,输入“CUDA Build ”下令 来编译CUDA程序假如 编译乐成 ,则 。

7、起首 ,查察 电脑的CUDA和GPU信息 ,利用 下令 行工具轻松实现打开下令 提示符或PowerShell,输入下令 nvidiasmi此下令 将出现 GPU型号驱动程序版本以及CUDA版本等紧张 信息比方 ,假设GPU型号为NVIDIA GeForce ,当前CUDA版本为114接着,查察 CUDA Toolkit版本,同样在下令 行输入nvcc version这将表现 。

8 、在举行 Linux体系 的CUDA Toolkit版本升级之前 ,起首 要选择得当 本身 的版本思量 因素包罗 显卡驱动版本与gcc版本和体系 版本的匹配度以及与GPU架构版本的匹配显卡驱动版本可以通过特定下令 查询查察 本地 gcc版本后,进入CUDA Toolkit的Archive页面在Versioned Online Documentation中,找到Installation Guide Linux。

9、win7体系 的话 ,在开始菜单找到Nsight 的文件夹,点击它,就可以看到它的userguide Linux体系 的话 , cuda安装目次 的doc子目次 下有Nsight_Eclipse_Edition_Getting_Startedpdf 。

10、固然 可以!固然 CUDACompute Unified Device Architecture是NVIDIA推出的一种并行盘算 平台和编程模子 ,它答应 开辟 者利用 GPU图形处理 惩罚 器举行 高性能盘算 ,从而加快 深度学习等AI应用的练习 和推理过程,但并不意味着不利用 CUDA就无法运行AI在不利用 CUDA的环境 下 ,我们可以选择利用 CPU举行 盘算 固然 相对于GPU,CPU。

11 、假如 我们在安装PyTorch时选择了与我们盘算 机上已安装的CUDA版本不兼容的版本,则也会出现此题目 点击学习大厂名师佳构 课第二步是利用 函数来查抄 是否已乐成 设置 CUDA环境 假如 输出结果 为True ,则PyTorch可以利用 GPU,否则为False,阐明 GPU不可用第三步是利用 device函数假如 。

12、你的静态库是编译后的x86代码 ,而你的CUDA核心 是不能实行 x86代码的,以是 肯定不能这么用你可以用CPU把Mat转换成根本 元素的数组,然后再交给CUDA处理 惩罚 。

13、由于 它答应 你继承 利用 认识 的numpy函数集 ,同时利用 GPU的加快 本领 总结而言,为了在Python中利用 GPU的加快 性能,起首 确保安装了CUDA和Cupy然后 ,在你的代码中用Cupy更换 掉numpy的调用即可这种方式为那些盼望 加快 现有Python代码的开辟 者提供了一条便捷的途径,无需重新 学习复杂的CUDA API。

14 、网上有大量关于GPU设置 CUDA和CUDNN+PyTorch+PyG的安装教程,但为什么我选择撰写这篇内容呢由于 安装过程常常 碰到 的题目 是版本兼容性,每个包的安装都依靠 于前面包的版本 ,一旦出现不匹配,安装就会失败因此,本文将引导各人 怎样 安装CUDACUDNNPyTorch和PyG ,并确保各版本之间的兼容性起首 ,访问。

15、CUDA#174 是 NVIDIA 创造的一个并行盘算 平台和编程模子 它利用 图形处理 惩罚 器 GPU 本领 ,实现盘算 性能的明显 进步 借助如今 已售出的数百万支持 CUDA 的 GPU ,软件开辟 职员 科学家和研 究职员 正在各种各样的应用程序中利用 GPU 加快 盘算 。

16、激活和退出环境 有多种方式,conda deactivate和source deactivate是退出base,source activate my_evn则是激活其他环境 可以设置服务器毗连 后主动 激活环境 ,具体 下令 可参考conda下令 备忘conda一些常用下令 备忘_Cl2212的博客CSDN博客安装PyTorch时,确保已安装对应CUDA版本的GPU版本通过nvcc V查察 CUDA。